自从ChatGPT横空出世、生成式AI最近爆火之后,人们惊奇地发现,新能源板块居然搭上了人工智能这趟高速列车。

半个月前,国内网络上疯狂流传着英伟达创始人黄仁勋的“AI的尽头是光伏和储能”。A股市场也随之风云激荡,锂电、光伏相关板块一通大涨,让人看得热血沸腾。作为当今科技圈的领军人物,“黄仁勋喊口号”显然具有极大的号召力,于是,这番言论给新能源投资者带来了巨大的信心提升和市场狂欢。

但很可惜,索比储能网查阅公开资料发现,黄仁勋并没有说过这样一句话。所以,上述故事的真相是什么?AI将助推新能源成为印钞机的“泼天富贵”到底是不是真的?

下面将会一一解答。

AI算力引发美国“电荒”

近几年,AI算力突飞猛进,就像是一匹奔腾的骏马,拉动着算力数据中心和服务器集群这辆“马车”疾驰向前。然而,这匹骏马“胃口”很大,得靠海量的电力来“喂养”。随着AI模型不断迭代升级,其训练和推理所消耗的能量随之飙升,总能耗也呈现指数级增长。

以近期爆火的Sora为例,Sora是美国人工智能公司OpenAI发布的人工智能文生视频大模型,在2024年2月15日发布。据悉,Sora可以根据用户的文本提示创建逼真视频,可以深度模拟真实物理世界,能生成具有多个角色、包含特定运动的复杂场景。能够理解用户在提示中提出的要求,是一款较为智能的人工智能大模型。

同时,Sora视频又耗电巨大,目前Sora制作视频最长不过60秒,但这60秒视频的耗电量超过一百度,以美国工业用电0.87美元一度电计算,Sora一分钟视频的电费成本超过90美元。

一般情况下,视频生成最长的时限在半小时比较合理。这意味着需要1800块英伟达A100算卡干4个小时。现在ChatGPT使用的是不到30000块A100,也就是说50万度电,够72个人生成半小时视频。该模型一旦正式发布,使用用户基数将最少百万级以上,仅仅一天的耗电量将可能会超过300亿度,这对全年发电量只有41781.71亿千瓦时的美国来说,显然是不可能完成的任务。

另据国际能源署(IEA)统计,谷歌搜索一次消耗0.3千瓦时电力,而ChatGPT搜索一次则消耗2.9千瓦时电力,而ChatGPT每天需要响应约2亿个用户请求,消耗超过50万千瓦时的电力,这个数额相当于美国家庭日常用电量的1.7万倍以上。

目前,亚马逊、苹果、谷歌、Meta和微软等科技公司正在全美范围内寻找新的数据中心地点,许多不太知名的公司也在寻找新的数据中心。随着耗电大户数据中心在全美各地激增,美国大片地区都面临着电力短缺的风险。同时,美国飙升的电力需求已经推迟了堪萨斯州、内布拉斯加州、威斯康星州和南卡罗来纳州燃煤电厂的关闭时间。

IEA预计,到2022年,美国2700个数据中心消耗的电力将占该国总电力的4%以上,到2026年,这一比例会达到6%。甚至有Nature相关论文做出了最坏的情况推算:到2030年代,全球生产电力的30%-50%将用于计算和冷却,这还不包括挖掘加密货币的能耗。

传言的真相是什么?

在AI算力引发美国电荒的背景下,近期国内网络流传起了几位AI大佬的发言,如英伟达创始人黄仁勋说:“AI的尽头是光伏和储能!我们不能只想着算力,如果只考虑计算机,我们需要烧掉14个地球的能源。”

OpenAI创始人奥特曼说:“未来AI的技术取决于能源,我们需要更多的光伏和储能。”

特斯拉CEO马斯克说:“现在是缺芯片,但预计接下来短缺的将是电力,明年,大家会看到,没有足够的电力来运行所有的芯片。”

实际上,无论是黄仁勋还是奥特曼,都没有说过“AI的尽头是光伏和储能!”这句话,只有马斯克那句话的真实性较高。

真相究竟是什么呢?

黄仁勋在2024年2月12日“世界政府峰会”上与阿联酋国务大臣OmarSultanAlOlama的谈话里,确实提到了AI和算力所需能源巨大,但他的原话如下:

“当我们替换通用计算的基础设施时,请记住架构的性能将不断提高。你不能只想着要购买更多的计算机,你还必须假设,计算机的速度会越来越快。因此,你所需要的总量就不会这么多了。”

“否则,如果你只是假设计算机的速度永远不会变快,你可能会得出一个结论——我们需要14个不同的行星、3个不同星系、4个太阳为这一切提供燃料。”

“但是很明显的是计算机架构不断进步。在过去的十年里,我们做出的最伟大贡献之一就是将计算和人工智能提高了一百万倍。因此,无论你认为推动世界的需求是什么,你都必须考虑到,它还将以100万倍的速度增长,变得更快和更高效。”

“当某些东西提高了一百万倍,而它所消耗的成本、空间或能源并没有增长一百万倍。事实上,你已经使这项技术大众化了。”

显然,黄仁勋的意思是由于计算机性能飞速增长,变得更加高效,所以不用无止境地配置计算机和数据中心,因此也不需要同比消耗那么多的能源。黄仁勋的本意是夸自己把算力提高了100万倍,相当于节约了更多的能源。

ChatGPT之父、OpenAI首席执行官山姆·奥特曼在2024年达沃斯论坛上的公开讲话中认为,未来的两种重要货币是算力和能源。“我们在世界上需要的能源确实比以前想象的要多得多。我对世界的构想是未来的两种重要货币是算力和能源。我认为我们仍然没有意识到技术对能源的需求。如果在能源方面不能取得突破,就不可能实现技术目标。这在某种程度上是好消息。”“我们需要核聚变或者更便宜的太阳能和储能,或者还没有人开始计划的其他大规模的能源技术。”

从这两个人的原话来看,黄仁勋并没有说过“AI的尽头是光伏和储能”这句话,奥特曼的一番讲话与传言更为接近。

中国能否支撑起算力电荒缺口?

无论是成本还是能耗,人工智能“吞金兽”的本质让很多国家望而却步,目前进展最快的当属美国和中国,但从后期耗电量来看,美国的发电量已经不足以支撑用电需求。

2024年初,国家能源局发布了2023年国内用电量的详细数据。2023年,全社会用电量92241亿千瓦时,同比增长6.7%,其中规模以上工业发电量为89091亿千瓦时。同期,美国全口径净发电量为41781.71亿千瓦时,同比下降1.2%。从全口径统计数据来看,中国全口径净发电量为89560.7亿千瓦时,是美国的2.14倍。从全社会用电量数据来看,中国是美国的2.3倍。

近年来,中国的发电总量约以10%的速度增长,美国发电总量则出现了一定程度的下滑。值得一提的是,中国新能源发电装机量发展尤为迅猛,在2023年6月,可再生新能源装机量还是13亿千瓦,也就是说半年的时间,中国可再生新能源装机量超过1.5亿千瓦。行业机构预测,2024年中国将占全球可再生能源新增容量的近55%。

从可再生能源的装机量来看,中国人工智能领域的发展速度似乎将会优于美国。但是,从中国和美国的发电总量来看,都难以支撑Sora大模型的全面运行。两国最终能否解决人工智能大模型高耗电量的缺口,解决方案也只有两个,要么大量增加发电满足需求,要么就是优化人工智能大模型成本,将高耗电降下来。

将为中国企业带来哪些利好?

跟据荷兰数据科学家deVries的论文,到2027年,整个AI行业将每年消耗850到1340亿千瓦时的电量。这相当于到2027年,人工智能的电量消耗可能占到全球电量的0.5%左右,这是一个相当惊人的数字,必然引发全球电力行业的剧变。

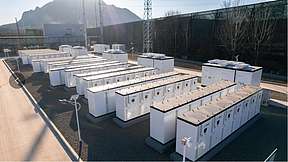

这如同天文数字的能源消耗,肯定不能依靠煤炭、石油、天然气这些不可再生资源,再考虑到AI算力的不可间断性,对电力的持续性供给有非常高的要求。近期爱尔兰等数据中心耗电量较高的国家的断电案例表明,AI时代对高效电力网络的建设已经提出了更高要求。随着高效利用光伏和控制对电网冲击需求的提升,对于储能有更大的配套需求,这对中国新能源+储能企业来说,当然是一个长期利好。

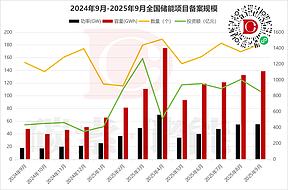

据摩根士丹利预测,光是在中国,储能需求在2024年-2026年年复合增长率就有24%,从长期来看,其对中国到2030年的储能需求从此前预测的500GWh水平直接接近翻倍,已经超900GWh。

传闻所说的“AI将助推新能源成为印钞机”用词虽然夸张,但在不远的将来必然产生重大影响。在一些业内人士看来,正是由于人类新增能源需求的不断推动,以风光和储能为代表的新能源产业才拥有了无比广阔、无限可能的未来空间。

此外,马斯克在提到AI技术会缺电之外,还提到了另一个问题:缺变压器。这是因为AI芯片在工作过程中,需要将电力公司供应的100-300千伏的高压电,一直降压到工作电压6伏,这是一个巨大的降压过程。

根据美国商务部2020年发布的报告数据显示,美国变压器的平均使用寿命已经达到了30、40年,远远超过25年的预期使用寿命。所以,美国在遭遇“电力荒”的同时也在经历着“变压器荒”。目前,美国变压器主要靠进口,而中国和印度正是变压器的主要出口国,这对中国变压器厂商来说,也是一个巨大利好。

碳索储能网 https://cn.solarbe.com/news/20240325/87444.html

下一篇

下一篇